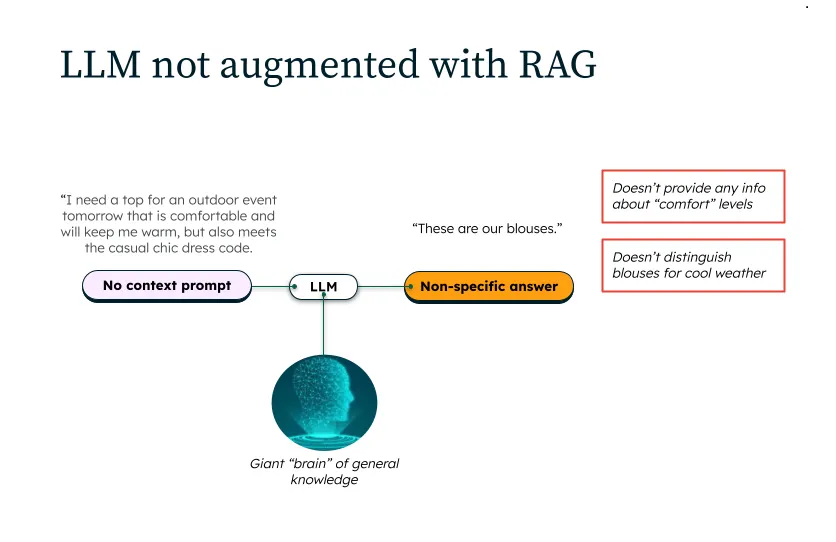

检索增强生成(Retrieval-Augmented Generation,简称 RAG)就像是为你的 AI 升级了内存,还配备了谷歌搜索栏。它不再根据训练时“认为”学到的内容编造答案,而是能获取实时、相关的信息——本质上,它不再“幻觉输出”,而是开始引用来源了。

试想一下,ChatGPT 能访问你收藏的书签、PDF 文件、Slack 对话记录,以及那些你早已忘记的、名字奇奇怪怪的谷歌文档,RAG 就能实现这样的效果。这好比把你的 AI 变成了那种会先读完群聊记录再回复的朋友,贴心又靠谱。

实际上,这意味着 AI 能给出更智能、更新鲜且上下文感知能力更强的回复。你可以把它看作一个不仅会猜测,还会先核实事实的 AI 助手——终于,在人与 AI 的互动中,有了“问责机制”。

下面为你介绍 10 个富有创意且对新手友好的项目思路,这些项目将大型语言模型(LLMs)与 RAG 相结合——每个项目都有好记的名称、明确的用途,以及恰到好处的技术支撑。

所以,拿起你常用的 Python 集成开发环境(我用的是 VS Code 或 Cursor),启动向量数据库,或许再打开一个 Streamlit 标签页——让 AI 忙着工作,你就安心等咖啡变凉吧。

现在,让我们开始深入了解这些项目。

PyPI(用于加载代码/文档)、LangChain 或 LlamaIndex(用于文档加载器和链)、FAISS 或 Chroma(向量数据库)、GPT-4 或 LLaMA-2(大型语言模型),以及简易前端(Streamlit 或 Slack 机器人)。